提起来自英国的芯片公司,ARM 可谓独揽美誉:这家只有不到 2000 人的公司,“统治” 着世界上 90% 以上的手机芯片,苹果、华为、三星所发布的各类芯片,归根结底还是 ARM-Base Chips。

不过,新生代力量也未缺席。Graphcore 是其中的代表性公司。

首先引发外界注意的是,这家公司的投资者名单中有不少 AI 领域的领袖级人物,包括 AlphaGo 之父、DeepMind 联合创始人哈萨比斯,剑桥大学教授 Uber 首席科学家 Zoubin Ghahramani,加州大学伯克利分校教授 Pieter Abbeel,OpenAI 联合创始人 Greg Brockman 等。明星机构投资者则有红杉等。

随着今年年初宣布 1.5 亿美元 D 轮融资,成立于 2016 年的 Graphcore 已筹集了超过 4.5 亿美元的风险投资基金,其估值达 19.5 亿美元。

英国半导体之父、ARM 的联合创始人 Hermann 爵士曾对 Graphcore 的芯片给出很高期望:“在计算机历史上只发生过三次革命,一次是70年代的 CPU,第二次是 90 年代的 GPU,而 Graphcore 就是第三次革命。”

充足的资金弹****,又有如此高的评价,也让 Graphcore 对其 2020 年的工作重点之一— — 吸引中国客户、打开中国市场颇有信心。

详解另类AI芯片产品代表 — — IPU

Graphcore 将其开发的人工智能芯片命名为 IPU(Intelligent Processing Unit / 智能处理器),在 2018 年就已量产上市。

过去几年,AI 芯片品类迎来物种大爆发,因此不乏一些颇为另类、甚至堪称疯狂的产品。比如在去年于顶会 Hot Chips,Cerebras Systems 就发布了史上最大半导体芯片 WSE,拥有 1.2 万亿晶体管,比最大的 GPU 大 56.7 倍。

Graphcore 开发的 IPU 也有一些大胆的想法。在近日接受 DeepTech 采访中,Graphcore 高级副总裁兼中国区总经理卢涛详细介绍了 IPU 背后的技术逻辑。

Graphcore 认为,AI 应是一个全新的应用架构,它底层表征是以计算图作为表征的,所以需要一种全新的处理器架构,而且,常见的将 AI 计算区分为训练和推理也不是可取的分类方向,新的 AI 计算架构本来就应该要具备同时处理二者工作的能力。

回顾处理器近年来的发展,从一个 teraflops 到十个 teraflops 再到现在的一百个 teraflops,算力提升的速度非常之快。但在发布会上展示的算力规格无论是几个 teraflops,与现实往往有差距:有效的算力远远达不到峰值。

造成这个现象的原因在于,芯片内存的带宽非常限制性能。

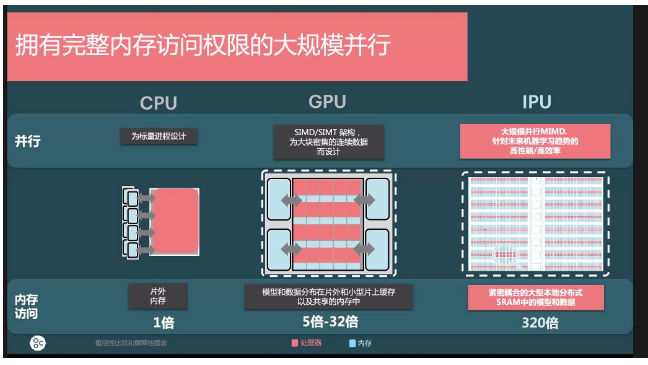

当处理器算力提高 10 倍,那内存应该如何提高 10 倍的性能?传统的 DDR4、DDR5、HBM、HBM1、HBM2、HBM3 的内存解决方案等,基本上每一代大概能有 30%、40% 的提升。在这方面,与传统的 CPU、GPU 相比,IPU 用了大规模并行 MIMD 的处理器核。另外做了一个非常大的分布式的片上 SRAM,在片内做到 300MB 的 SRAM,相对 CPU 的 DDR2 子系统或者是相对于 GPU 的 GDDR、HBM 来说,可以做到 10 到 320 倍的性能提升。从时延的角度来看,与访问外存相比较,时延基本上就是 1%,可以忽略不计。

另外,IPU 是一个标准的神经网络处理芯片,而且规模很大,通常具备数千到数百万个顶点,除了标准神经网络之外,也适用于贝叶斯网络(也称为信度网络、因果网络,是指基于概率分析、图论的一种不确定性知识的表达和推理的模型)和马尔科夫网络(马尔可夫网络类似贝叶斯网络用于表示依赖关系。但是,一方面它可以表示贝叶斯网络无法表示的一些依赖关系,如循环依赖;另一方面,它不能表示贝叶斯网络能够表示的某些关系,如推导关系),而因为架构具备弹性,未来的新模型与算法理论上也都能够完美支持。

由于其庞大的顶点数量,远超出现有最大 GPU 的规模数百倍,这也意味着其在并行工作的处理潜力非常惊人。另外,这些顶点都是稀疏的,绝大多数顶点都只连结到其他一小部分顶点。另外,IPU 也是针对低精度的数据模型优化,也就是具备数据的统计近似值概念,这和过去超算的概念完全不同。另外,IPU 也支持了模型参数的复用。简单来说,卷积是空间复用,回归是时间复用。这些复用特性可以获取数据中的空间或时间不变性,对于训练与推理的性能会有明显帮助。

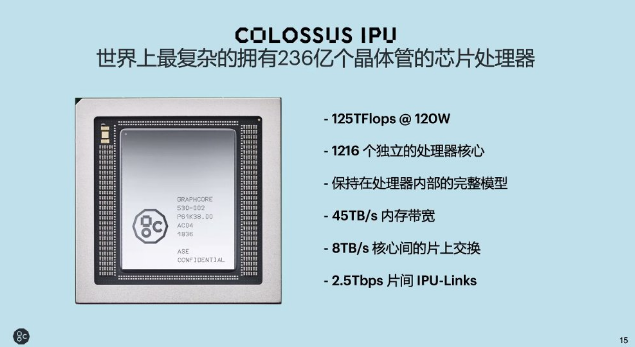

从整体上看 IPU,目前已经量产的是 GC2 处理器,采用 TSMC 16nm 工艺。该处理器目前片内有 1216 个 IPU-Tiles,每个 Tile 中有独立的 IPU 核作为计算以及 In-Processor-Memory,即处理器之内的内存。所以对整个 GC2 来说,共有 7296 个线程,能够支持 7296 个程序并行运行。对整片来说,In-Processor-Memory 总共是 300 MB。

据介绍,IPU 的整个设计思想是要把所有的模型放在片内处理。

在各个核心之间的 BSP 同步,能支持同一个 IPU 处理器之内 1216 个核心之间的通信,以及跨不同的 IPU 之间做通信。这都是通过 BSP 的同步协议实现,之间还有一个非常高速的 IPU exchange、8 TB/s 的多对多交换总线。

另外,在 IPU 和 IPU 之间还有 80 个 IPU-Links,构成 320 GB/s 的芯片与芯片之间的带宽。如此一来,同一个处理器就同时支持了训练和推理。

目前来看,IPU GC2 是世界上非常复杂的拥有 236 亿个晶体管的芯片处理器,在 120 瓦的功耗下有 125TFlops 的混合精度、1216 个独立的处理器核心(Tile)、300M 的 SRAM 能够把完整的模型放在片内,另外内存的带宽有 45 TB/s、片上交换 8 TB/s,片间的 IPU-Links 是 2.5 TB/s。

而诸如 IPU GC2 有 1216 个核心(Tile)、7000 多个线程,解决并行硬件的高效编程问题又是一个非常大的课题。

为此,Graphcore 采用构建大规模数据中心集群的 BSP 技术(Bulk Synchronous Parallel)。该技术目前在谷歌、Facebook、百度这样的大规模数据中心内均已得到应用。

因而,IPU 也是目前世界上第一款 BSP 处理器,通过硬件能支持 BSP 协议,并通过 BSP 协议把整个计算逻辑分成了计算、同步、交换,对软件工程师或开发者来说十分友好。

Graphcore 在 IPU 设计上应用了很多相当极端的想法,虽然理论上以其规模应该更适合放到云端,但 Graphcore 认为 IPU 架构拥有很好的伸缩性,边缘或是终端计算同样能良好胜任。

积极融入中国 AI 生态圈

技术以外,和一些 AI 芯片公司其产品仍停留在 PPT 阶段不同,IPU 在 2018 年就已量产上市。

目前,Graphcore 客户名单上已有微软、Citadel 和 Qwant。其中,最为外界瞩目的公司还是科技巨头微软。

近年来,越来越多的科技巨头希望使用专门的人工智能硬件以加速数据中心,对高性能计算芯片的需求正在迅速增长。我们耳熟能详的几个名字正在该领域进行积极的收购和合作,例如,英特尔就曾斥资 20 亿美元收购了 Graphcore 的竞争对手、以色列公司 Habana Labs。

显然,对初创公司来说,长期稳定的发展除了自身要有强大的实力外,与外界的合作联系也十分必要。

2019 年 11 月,Graphcore 宣布与微软达成合作,在微软的云计算平台 Azure 上部署其 AI 处理器。此次合作不仅将增加 Graphcore 的AI芯片使用率,还有可能扩大其客户群。

2020 年,Graphcore 的一个重要目标是开拓中国市场。

刚刚过去的 5 月,其融入中国 AI 生态圈的诸多进展得以公布:在 OCP Global Summit 上,阿里巴巴异构计算首席科学家张伟丰博士宣布了 Graphcore 支持 ODLA 的接口标准;在百度 Wave Summit 2020 上,百度集团副总裁吴甜女士宣布 Graphcore 成为飞桨硬件生态圈的创始成员之一,双方签署了倡议书。

“Graphcore 策略上是要积极拥抱中国的 AI 生态圈。通过这样一种方式融入中国 AI 生态圈,在于我们认为除了像国际上比较流行的 TensorFlow、PyTorch 以外的框架,中国本土的机器学习框架也会有出色表现。

长期来说,我们对中国市场的期望非常高,期望中国市场能够占到 Graphcore 全球市场的 40% 甚至 50%。虽然我们在中国市场的整体启动比北美晚了近一年,但从目前进展来看,前景还是非常不错的。” 卢涛表示。

市场竞争进入启动期,“有两类 AI 芯片公司或被淘汰”

不过他也强调,生态以外,AI 芯片本质上仍需回归技术攻坚。

以年初轰动业界的 Wave Computing 倒闭为例,其诞生之初也有着明星企业的光环,最终却黯然退场。

卢涛认为,Wave Computing 的倒闭并不意味着 AI 领域遇到寒冬,“全球 AI 发展并没有走向低潮,今年反而会有更****展。”

据了解,自然语言处理是需要强劲算力的一大类 AI 应用。

“NLP 相关技术的崛起会催生大量的、各种各样的应用,以及在算力方面的大幅提升。现在一般的 CV 类模型是几兆的参数、几百万或者几千万的参数,而更大一些的 NLP 模型,现都是一亿、十亿、一百亿的参数容量,对算力的要求是指数级的。所以,我们认为,AI 芯片产业存在这样一个问题,即一个 AI 处理器从作为一个处理器到最后商业落地,其实中间的落差还是非常大的。”

开发出芯片只是第一部分,出来之后配套的是不是有比较好的工具链,是不是能够有比较丰富的软件库来支撑主流算法,以及是不是能够跟主流的机器学习框架进行无缝连接,最后对用户来说展现的是比较好的可移植性或者是可开发性/可部署性,最终差距其实还有很多。所以,整个链条全部打通的话需要非常大的投入。

而他也强调,有两种类型的 AI 芯片公司将会遭遇困境:一类是处理器仍未量产的公司;第二类是有了处理器,但对软件重视不够的公司。“没有足够投入的话,未来面临的会是困难局面。”

“2020 年对 AI 芯片确实是非常关键的一年。因为全球有很多企业都在开发 AI 处理器,但是否这些处理器真能做出来、是否真的能够有一些场景落地?如果说拿不出来,那么对于后期持续化的投入,可能是一个非常大的挑战”。

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。